De hautes grilles protègent la vaste enceinte circulaire d’une vingtaine de mètres de hauteur. De loin, l’ensemble a le magnétisme d’un stade de foot. A la Courneuve, en Seine-Saint-Denis, à quelques encablures de l’antre des Bleus, l’hypothèse n’aurait rien d’extravagant. Couvert d’un voile façon tissu Jacquard, le plus gros centre de données de France, ou data center, doit se fondre dans le décor. A l’intérieur, ni pelouse ou ni vestiaires, mais près de 40 000 mètres carrés de serveurs informatiques. L’équivalent, au sol, de sept terrains de football.

Une véritable “usine du numérique”, décrit Fabrice Coquio, directeur France de l’entreprise Digital Realty, qui administre les lieux. Dans le cœur du site, masqué par d’épais murs et de multiples sas de sécurité, les machines bourdonnent. Le bruit provient des amas de data, que l’endroit reçoit, redirige, parfois stocke, des centaines de vidéos prises sur nos téléphones portables, aux séries Netflix. Lors des Jeux olympiques de Paris, c’est ici, qu’ont circulé les flux vidéo ou encore les chronos dingues des courses de natation de Léon Marchand. Le prochain enjeu tient en deux lettres : IA.

“On est face à un mur de données”, souffle Fabrice Coquio. Une partie de son centre de la Courneuve sera consacrée à l’intelligence artificielle, pour opérer le traitement et le calcul nécessaire à la génération de textes ou d’images. Mais face à la quantité d’énergie demandée – l’IA est plus énergivore que d’autres technologies – “il faudra en construire d’autres”, assure Jérôme Totel, dirigeant de Data4, un autre opérateur. Selon lui, à terme, “entre 20 et 25 % des data centers en Europe seront consacrés à l’IA”. La France place ses pions. Data4 entend investir 2 milliards d’euros dans l’Hexagone et bâtit actuellement plusieurs centres dans l’Essonne, à Nozay. Digital Realty a, lui, déjà officialisé un nouveau méga centre, à Dugny, au nord de la Courneuve. Le géant Microsoft a annoncé le sien sur la commune de Petit-Landau (Alsace), d’ici à 2027-2028.

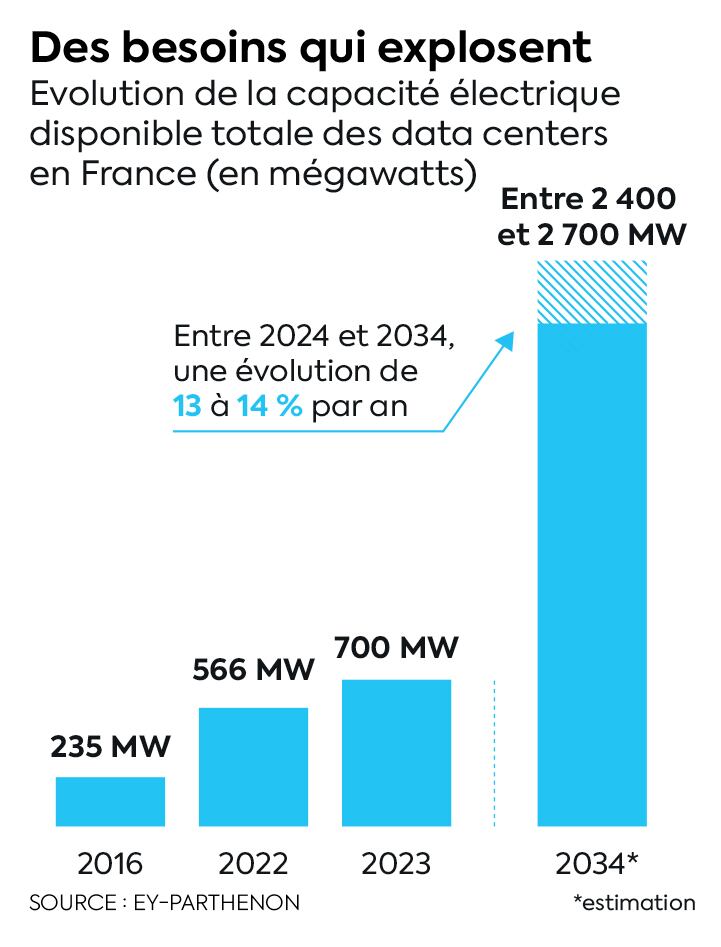

Lors du dernier Choose France, plus de 5 milliards d’euros d’investissements ont été injectés dans les centres de données dimensionnés pour l’IA, avec des acteurs comme Amazon, Equinix et Telehouse… De fait, alors que la puissance disponible en faveur des data centers est estimée à 500 mégawatts (MW), elle pourrait se situer entre 2 400 et 2 700 MW d’ici à 2034, pointe Thomas Solelhac, consultant chez EY-Parthenon. Soit l’équivalent d’un peu plus de deux réacteurs nucléaires.

Le soutien de l’Etat à la filière

Cette croissance rapide – entre 13 à 14 % par an – viendrait compenser un “retard” de la France dans les centres de données, juge Thomas Solelhac. Les Etats-Unis ou la Chine disposent de très nombreux lieux de stockage ou de calcul des data. En Europe, la France allouait jusqu’à récemment deux fois moins d’énergie disponible à ces tâches que son voisin allemand. Le Royaume-Uni compte à ce jour deux fois plus de centres que la France – environ 260 dans tout l’Hexagone. Et l’Irlande et les Pays-Bas, hôtes de nombreux sièges de la tech européenne, étaient traditionnellement d’importants concurrents.

Mais face à l’essor de l’intelligence artificielle, la France œuvre à devenir un nouvel éden des data centers. Une loi de simplification – bloquée dans les couloirs de l’Assemblée en raison de la situation politique – devrait permettre de délivrer des permis de construire et de procéder à des raccordements électriques plus rapidement. “Un point faible jusqu’ici, qui poussait les investisseurs à aller voir ailleurs”, remarque Thomas Solelhac. Les multiples connexions aux câbles sous-marins, essentiels pour des questions de réseau, de latence, sont également un argument pour attirer les capitaux. Tout comme le soutien du pays à la filière IA, dans le cadre du plan France 2030. Mais c’est un autre atout tricolore qui intéresse le plus les industriels : l’accès à un mix énergétique largement décarboné grâce au nucléaire.

“Un argument séduisant quand on scrute l’indicateur de l’empreinte carbone”, convient Abdoulaye Gamatié, directeur de recherche CNRS au Laboratoire d’informatique, de robotique et de microélectronique de Montpellier (Lirmm). Conscients du besoin impérieux d’accéder à des électrons verts pour faire tourner leurs serveurs, les géants de la tech multiplient les contrats d’achat d’électricité issue d’énergies renouvelables (PPA, pour Power Purchase Agreement), permettant de garantir, sur le long terme, un prix prédéfini et stable. Jusqu’ici, ces PPA se développaient prudemment en France “par rapport à d’autres pays européens” comme le Danemark, la Belgique ou bien l’Irlande, reconnaissait, en 2022, la Commission de régulation de l’énergie (CRE). Mais Data4, Equinix ou Digital Realty les multiplient désormais dans l’Hexagone. Microsoft, en mai, dans le cadre de son investissement de 4 milliards d’euros, a lui aussi annoncé négocier un PPA.

“Le diable se cache dans les détails”

Que peut gagner la France à multiplier les centres ? Plus de souveraineté, d’après Bruno Le Maire. En 2019, le ministre de l’Economie, avait martelé son intention de faire de la France le “champion européen des data centers”. Héberger ses données en Europe, a fortiori en France permet de mieux les protéger de menaces extérieures – consultations par des puissances étrangères ou vols.

Mais c’est économiquement que le pari est sûrement le plus intéressant. Construire des data centers est une des recommandations du rapport du comité IA délivré au printemps, “afin de passer à l’échelle une réelle transformation des services publics grâce au numérique et à l’IA, pour les agents et au service des usagers”. Ces centres de données, en particulier ceux des mastodontes américains, se proposent d’acheter les puces très onéreuses nécessaires au calcul. “A ce jour, la grande majorité des entreprises qui veulent profiter de l’IA ne peuvent supporter eux-mêmes les coûts d’infrastructures”, souffle un acteur français du secteur. Les data centers français vantent 5 milliards d’euros de valeur ajoutée directe (leurs chiffres d’affaires) et indirecte (en soutenant la transformation numérique des entreprises) en 2023, pointe l’organisation France Datacenter dans son rapport de juin, réalisé avec EY-Parthenon. La filière croît sept fois plus rapidement que le reste de l’économie française et emploie 28 000 personnes à temps plein, dont la quasi-totalité en CDI.

Sur le plan énergétique, en dépit d’une pression croissante, la France peut encaisser. RTE, le gestionnaire du réseau, anticipe une consommation passant de 10 TWh au début de la décennie à 15 voire 20 en 2030, puis entre 23 et 28 en 2035. Soit l’équivalent, à cette échéance, de la consommation électrique pour l’eau chaude sanitaire et le chauffage du secteur tertiaire. “C’est une hausse significative mais qui reste gérable”, rassure Jean-Philippe Bonnet, directeur adjoint stratégie, prospective et évaluation chez RTE. Ce n’est pas le cas partout. En Irlande, en 2023, la consommation des data centers a dépassé celle de l’ensemble des maisons en ville, soit plus d’un cinquième de l’électricité de l’île. Et les autorités ont mis le holà.

“Il y a eu beaucoup de progrès des opérateurs dans l’efficacité des data centers, et plusieurs techniques incitent à l’optimisme”, nuance Abdoulaye Gamatié. La réglementation oblige surtout ces derniers à plus de transparence, puisqu’une directive européenne leur impose désormais la publication annuelle d’informations sur leur performance énergétique. Dont celle du PUE (Power Usage Effectiveness), indicateur de référence du secteur, et situé plus bas que la moyenne en France. “Tout ne dépend pas des data centers”, précise Charles Sutton, cofondateur de Datascientest. Les puces dédiées au calcul (GPU) et les équipements énergivores des data centers ne sont pas sélectionnés par les opérateurs de ces derniers mais par leurs clients. Le leader des puces IA, Nvidia, a récemment présenté une nouvelle gamme de produits moins énergivore. “Mais le diable se cache toujours dans les détails, relève Abdoulaye Gamatié. S’il y a effectivement des gains d’efficacité, il faut également regarder, en face, les usages et la demande. Inévitablement, la consommation finit par augmenter.”

Des Gafam assoiffés

Guillaume Carnino, historien des sciences et techniques, rappelle en effet que les opérateurs de data centers ont toujours été “surpris” par l’expansion des données, que ce soit avec l’essor des réseaux sociaux, du streaming vidéo, ou du cloud. Et que le “bricolage” a souvent été la norme pour adapter ces bâtiments aux besoins énergétiques croissants. D’autres innovations, c’est certain, viendront encore alimenter le robinet de données. Thomas Solelhac, de EY-Parthenon, reconnaît également des prévisions de croissance qui se sont toujours révélées “fausses”. Disons, sous-estimées. Des voix s’opposent de ce fait au blanc-seing laissé aux data centers.

“Plutôt que de toujours accélérer, il s’agirait de faire une pause”, exhorte l’urbaniste Cécile Diguet, dans une tribune à La Croix. Afin de s’éviter un scénario à l’irlandaise. Ou à la néerlandaise. Car l’IA pose aussi des problèmes nouveaux dans la gestion de l’eau. Dans la municipalité de Middenmeer, au nord des Pays-Bas, le data center de Microsoft aurait consommé près de 84 millions de litres d’eau en 2021, bien loin des 12 à 20 millions initialement estimés par la mairie et la firme. Cette dernière, selon les chiffres disponibles pour l’année 2022, a augmenté sa consommation d’eau de 34 % par rapport à l’année précédente.

Auparavant, les data centers étaient refroidis à l’air. Ou par des systèmes de refroidissements adiabatiques, sorte de brumisateurs des salles serveurs. Leur densité augmentant, l’élément liquide a dû être davantage mobilisé pour refroidir les serveurs. L’IA pourrait affoler les compteurs. L’an dernier, une étude américaine intitulée “Making AI less thirsty” estimait qu’un échange de 20 à 50 questions avec ChatGPT consommait l’équivalent d’une bouteille d’eau de 50 centilitres. Or la plateforme créée par OpenAI traite déjà pas moins d’un milliard de requêtes par jour. La prudence reste de mise tant que d’autres travaux n’ont pas confirmé les données de cette étude. Mais elle a le mérite d’avoir mis en lumière une empreinte hydrique jusqu’à présent négligée.

Afin de compenser cette soif croissante, les opérateurs, en premier lieu les Gafam, cherchent la parade. Une de leurs promesses phare ? Etre “water positive” d’ici à 2030, c’est-à-dire consommer moins d’eau qu’ils n’en réapprovisionnent. Un concept séduisant… S’il n’était pas si flou. “Cela ressemble à la compensation carbone. On a du mal à savoir comment comparer l’eau consommée dans un centre de données avec des indicateurs d’eau ‘préservée’ ou ‘restaurée’ dans des lieux différents”, critique Aurélie Bugeau, professeure à l’université de Bordeaux et membre du Laboratoire bordelais de recherche en informatique (LaBRI). La prise en compte des enjeux liés à l’eau est à la fois tardive et poussive. “Un Water Usage Effectiveness est en cours de construction, mais l’indicateur n’existe pas aujourd’hui de façon homogénéisée”, regrette Clément Marquet, coordinateur du groupe de travail “Politiques environnementales du numérique” au CNRS.

Le casse-tête du foncier

Enfin, à l’ère des méga data centers comme celui de la Courneuve, des défis fonciers persistent. L’Ile-de-France et l’agglomération de Marseille – où la mairie a mis sur pause les constructions – ont du mal à leur trouver de la place. Le secteur doit trouver de nouvelles destinations. Des portes s’ouvrent : le Grand Est, en plein renouveau industriel, apparaît comme un candidat de choix. Car en plus du projet de Microsoft, le groupe Bolloré a annoncé une gigafactory de batteries électriques du côté de Mulhouse. “C’est une zone de l’industrie historique qui cherche à se décarboner”, note Jean-Philippe Bonnet. RTE va ainsi y créer un hub électrique pour plus de 100 millions d’euros. La région bordelaise, reliée à Boston (Etats-Unis) via un nouveau câble sous-marin, devrait elle aussi attirer plus de projets. Mais d’autres destinations se ferment. A Rennes, d’après la presse locale, la maire Nathalie Appéré s’est opposée cette année à l’installation d’un campus de data centers Microsoft en raison de son emprise foncière importante.

Le secteur, plus que jamais, tente d’arrondir les angles. Les entrepreneurs sautent sur les occasions de réhabiliter des friches industrielles. Certains exploitent la “chaleur fatale” des équipements, afin de chauffer des logements neufs environnants. C’est le cas sur le plateau de Saclay (Essonne). Et le secteur multiplie les innovations. Comme le direct liquid system (refroidissement par liquide direct), qui permet à l’eau de circuler dans une boucle fermée : le liquide froid est envoyé au plus près des composants chauds, dont il absorbe la chaleur, avant de repartir vers un échangeur qui le refroidit à nouveau. Ou encore l’immersion cooling qui mise sur le refroidissement par immersion dans une huile minérale spéciale. “Les opérateurs de data centers n’hésitent plus à faire de la pub pour leurs systèmes qui permettent de réaliser des économies en eau. C’est devenu un argument commercial”, estime Aurélie Bugeau. Un effort est également fait pour rendre ces usines visuellement “acceptables”.

Et ensuite ? Thomas Solelhac prédit aux data centers une trajectoire semblable aux entrepôts tels que ceux d’Amazon. Des infrastructures forcées par leur taille, leur emprise énergétique et territoriale, à l’exode vers les périphéries. Avant, petit à petit, de revenir vers les centres urbains sous une autre forme. Ces data centers dits “edge” prendront la forme d’enceintes réduites mais situées plus proches des villes, voire au cœur des quartiers d’habitation. Elles permettront de nouveaux usages en quasi-temps réel, comme du contrôle automatique d’engins logistiques, d’objets connectés, de voitures autonomes… Les centres de données se fondront toujours plus dans le décor. Jusqu’à en faire totalement partie.

Source